Llama.cpp это инструмент с открытым исходным кодом для эффективного вывода больших языковых моделей. Запускайте LLM-модели с открытым исходным кодом локально везде.

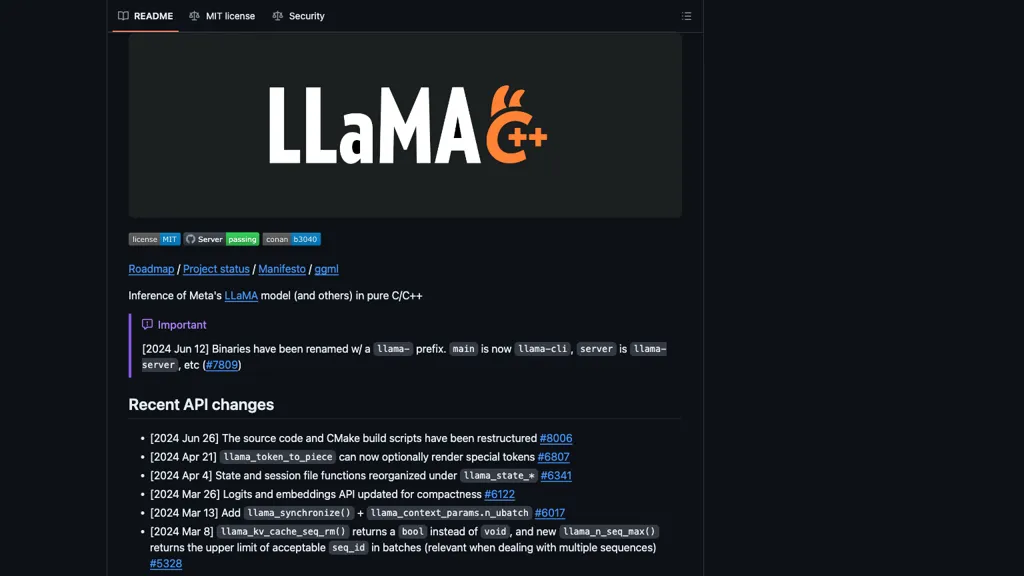

Llama.cpp

Платформы: Магистр права

Что такое Llama.cpp? Llama.cpp это инструмент с открытым исходным кодом, предназначенный для эффективного вывода больших языковых моделей (LLM) на C и C++. Он предлагает разработчикам, работающим с моделями искусственного интеллекта, упрощенный интерфейс, позволяющий легко интегрировать различные LLM и управлять ими. Ключевые функции включают поддержку нескольких серверных систем, таких как CUDA, Vulkan и SYCL, что обеспечивает универсальность развертывания. Инструмент также упрощает рабочие процессы непрерывной интеграции/непрерывного развертывания (CI/CD), повышая автоматизацию разработки программного обеспечения. Использование Llama.cpp может значительно повысить качество кода и производительность за счет автоматизации развертывания моделей и возможности быстрой модификации. Это делает его идеальным для инженеров-программистов, исследователей и организаций, которые хотят интегрировать возможности искусственного интеллекта в свои приложения.

Основные функции

⭐ Llama.cpp основные функции и преимущества Llama.cpp предлагает множество функций и преимуществ, которые делают его лучшим выбором для различных пользователей. Вот некоторые из ключевых функций: ✔️ Автоматизация любого рабочего процесса. ✔️ Размещение пакетов и управление ими. ✔✅ Мгновенные среды разработки. ✔️ Поиск и навигация по коду в режиме реального времени. ✔️ Автоматическое обнаружение уязвимостей в коде.

Примеры использования

➡️ Llama.cpp примеры использования и приложения Интегрируют большие языковые модели в настольные приложения с помощью Llama.cpp, используя поддержку CUDA для оптимизации производительности и удобства работы с пользователем. Автоматизируйте развертывание моделей искусственного интеллекта в облачных средах с помощью возможностей CI/CD от Llama.cpp, обеспечивая постоянное обновление и улучшения без ручного вмешательства. Улучшайте исследовательские проекты, используя Llama.cpp для легкого переключения между различными серверными системами LLM, такими как Vulkan и SYCL, что позволяет проводить всестороннее тестирование и анализ производительности модели.